1.创建raid0:

指定riad级别、磁盘数量和使用的磁盘

mdadm --create /dev/md0 --level=0 --raid-devices=8 /dev/sd[c-j] mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

2.从磁盘创建PV

[root@mongodb1 tianqi]# pvcreate /dev/md0 Physical volume “/dev/md0” successfully created

3.创建VG

[root@mongodb1 tianqi]# vgcreate VG1 /dev/md0 Volume group “VG1” successfully created

4.创建lv并使用全部的空间

[root@mongodb1 tianqi]# lvcreate -l 100%FREE -n LV1 VG1 Logical volume “LV1” created.

5.查看创建的lv

[root@mongodb1 tianqi]# lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert LV1 VG1 -wi-a—– 399.75g

6.创建配置文件,否则重启系统后raid可能会丢失

[root@mongodb1 tianqi]# echo DEVICE /dev/sd[c-j] > /etc/mdadm.conf [root@mongodb1 tianqi]# mdadm -Ds >> /etc/mdadm.conf

7.查看生成的配置文件:

[root@mongodb1 tianqi]# cat /etc/mdadm.conf DEVICE /dev/sdc /dev/sdd /dev/sde /dev/sdf /dev/sdg /dev/sdh /dev/sdi /dev/sdj ARRAY /dev/md0 metadata=1.2 name=mongodb1:0 UUID=037701ed:533c2d74:119d2da2:f2fec1af

8.格式化lv:

[root@mongodb1 tianqi]# mkfs.ext4 /dev/mapper/VG1-LV1

9.设置开机自动挂载磁盘:

[root@mongodb1 tianqi]# blkid /dev/VG1/LV1 #计算UUID,这样不会因磁盘名称发生变化而导致开机挂载失败 /dev/VG1/LV1: UUID=”5940e6fa-6aae-449e-aff7-673c5b689386″ TYPE=”ext4″ [root@mongodb1 tianqi]# mkdir /mongodb #挂载目录 [root@mongodb1 tianqi]# vim /etc/fstab #编辑fstab文件,添加下面一行 UUID=”5940e6fa-6aae-449e-aff7-673c5b689386″ /mongodb ext4 defaults 0 0 [root@mongodb1 tianqi]# mount -a #执行全部挂载

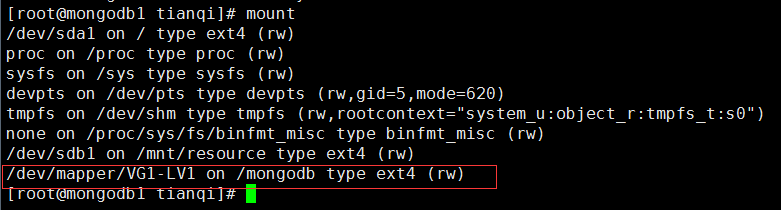

10.验证挂载:

[root@mongodb1 tianqi]# mount

运维那些事

运维那些事